目录导航

Grawler简介

Grawler是用PHP编写的工具,具有一个Web界面,该界面可自动执行使用Google dork的任务,抓取结果,并将其存储在文件中。

Grawler旨在通过网络界面自动执行使用Google dork的任务,主要思想是提供一个简单但功能强大的工具,任何人都可以使用,Grawler预先加载了以下功能。

特征

- 支持多种搜索引擎(Google,Yahoo,Bing)

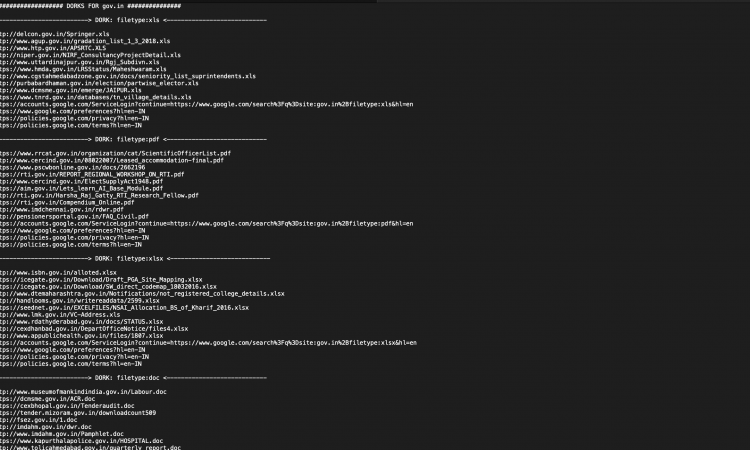

- 随附包含dork的文件,到目前为止,该文件已分为三类。

- 文件类型

- 登录页面

- SQL注入

- My_dorks(此文件有意留为空白,以便用户添加自己的dork列表)

- 附带了自己的指南,以学习Google dork的艺术。

内置功能以使用代理(以防Google阻止您)

- 将所有已抓取的URL保存在一个文件中(名称需要在输入字段中以扩展名.txt指定)。

- Grawler可以在四种不同模式下运行

- 自动模式:Grawler使用文件中存在的dork并存储结果。

- 启用代理的自动模式

- 手动模式:此模式适用于只想针对域测试单个dork的用户。

- 启用代理的手动模式

Grawler设置

- 下载ZIP文件

- 下载XAMPP服务器

- 将文件夹移动到XAMPP中的htdocs文件夹

- 导航到http://localhost/grawler

演示视频

- 如何运行Grawler?

- 有几种使用proxy的方法,我个人使用过,因为它们提供了没有任何信用卡信息或任何东西的免费API调用,您甚至可以免费获得更多API调用。

- 如何在手动模式下运行Grawler?

样品结果

验证码问题

有时,谷歌验证码可能是一个问题,因为谷歌正确地检测到该机器人并试图阻止该机器人,所以我已经尝试过以下几种方法来避免验证码:

- 在循环算法中使用不同的用户代理标头和IP。

- 它可以工作,但是它提供了许多无用的垃圾URL,此外它还很慢,因此我删除了该功能。

- 使用免费的代理服务器

- 免费代理服务器太慢,并且由于许多人使用这些免费代理服务器进行抓取而经常将其阻塞。

- 睡眠功能

- 这在某种程度上可行,因此我已将其合并到代码中。

- Tor网络

- 不,不是每次尝试都无法正常工作,但显示了一个漂亮的验证码,所以我也删除了此功能。

解决方法

- 我发现最好的解决方案是注册并使用代理服务,它以较少的垃圾URL产生了良好的效果,但有时可能很慢

- 使用VPN。

- 使用代理工具。

项目地址:

GitHub: github.com/A3h1nt/Grawler